Lundi 13 mai, à la veille de la conférence Google I/O, le géant de l’intelligence artificielle OpenAI a organisé une des premières conférences de presse de son histoire. Le créateur de ChatGPT, qui se contente habituellement de billets de blog pour faire des annonces, a dévoilé le nouveau modèle de langage GPT-4o, un nouveau mode ChatGPT Voice, l’arrivée de ChatGPT Vision et des GPTs pour tous les utilisateurs et une application desktop ChatGPT, sur Mac d’abord, puis sur Windows. GPT-5 et le moteur de recherche OpenAI, attendus de longue date, arriveront plus tard.

Avec GPT-4o, OpenAI fait basculer son agent conversationnel dans l’ère du film Her, avec des réponses ultra-rapides, la possibilité de lui couper les paroles, des talents d’imitation et un mode Vision pour commenter un flux vidéo en temps réel. GPT-4o peut aussi recevoir du texte par copier-coller pendant qu’il parle, pour gagner des informations. Voici le résumé détaillé de la conférence.

GPT-4o arrive dès aujourd’hui dans ChatGPT

Dans les prochaines semaines, GPT-4o remplacera GPT-3.5 (gratuit) et GPT-4 (payant). C’est la première fois qu’un nouveau modèle de langage OpenAI est disponible pour tous les utilisateurs de ChatGPT, ce qui peut laisser supposer que GPT-5 ne tardera plus à être annoncé. Les abonnés ChatGPT Plus seront les premiers servis (dès aujourd’hui pour les plus chanceux), avant un déploiement plus global. La fonction Voice/Vision, elle, arrivera plus tard pour les abonnés Plus d’abord.

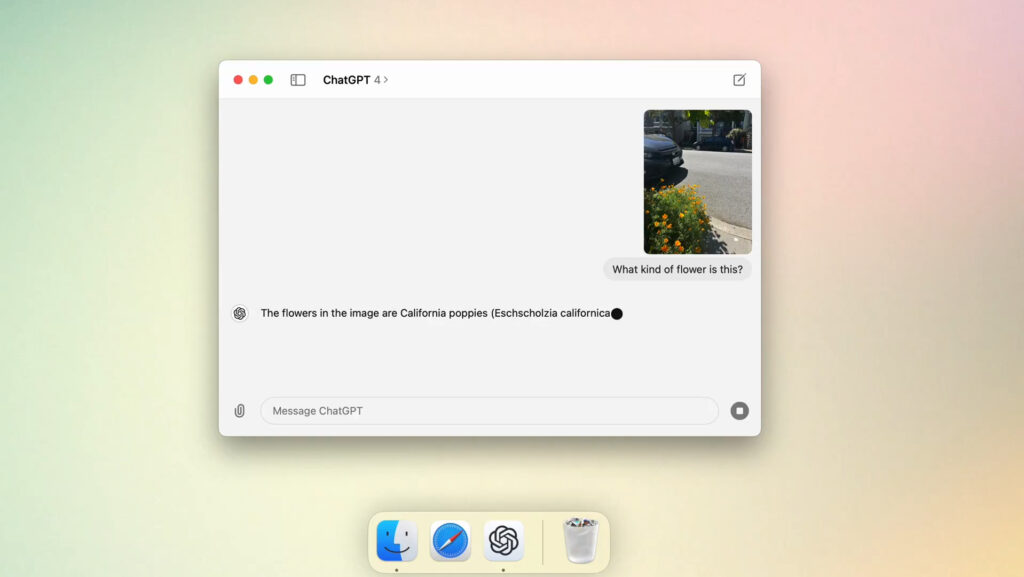

ChatGPT pour Mac, qui intègre un raccourci clavier pour le déclencher, arrive dès aujourd’hui. La version Windows arrivera plus tard.

La grande force de GPT-4o est sa capacité à traiter de l’image et de l’audio « nativement », presque sans délai. OpenAI mise beaucoup sur cet aspect, alors que la rumeur d’une alliance avec Apple pour remplacer Siri par ChatGPT circule.

Google, pendant sa conférence I/O, compte annoncer un concurrent de ChatGPT Voice, lui aussi capable de commenter des images en temps réel.

Toutes les annonces d’OpenAI minute par minute (et le replay de la conférence)

La conférence d’OpenAI a duré 26 minutes et peut être revue sur YouTube. Elle est disponible ci-dessous :

Si vous préférez lire un résumé commenté, Numerama, qui est à San Francisco pour la Google I/O, vous propose un live-blog de la conférence. Les dernières informations apparaissent en haut, vous pouvez aller en bas de la page pour rattraper la conférence depuis le début :

19h29 : Sur Twitter, Sam Altman confirme que le modèle gpt2, en fuite ces derniers jours, était GPT-4o.

19h26 : OpenAI promet un déploiement de GPT-4o dans les prochaines semaines, ainsi que des infos sur « the next big thing » (comprenez GPT-5). La conférence est finie.

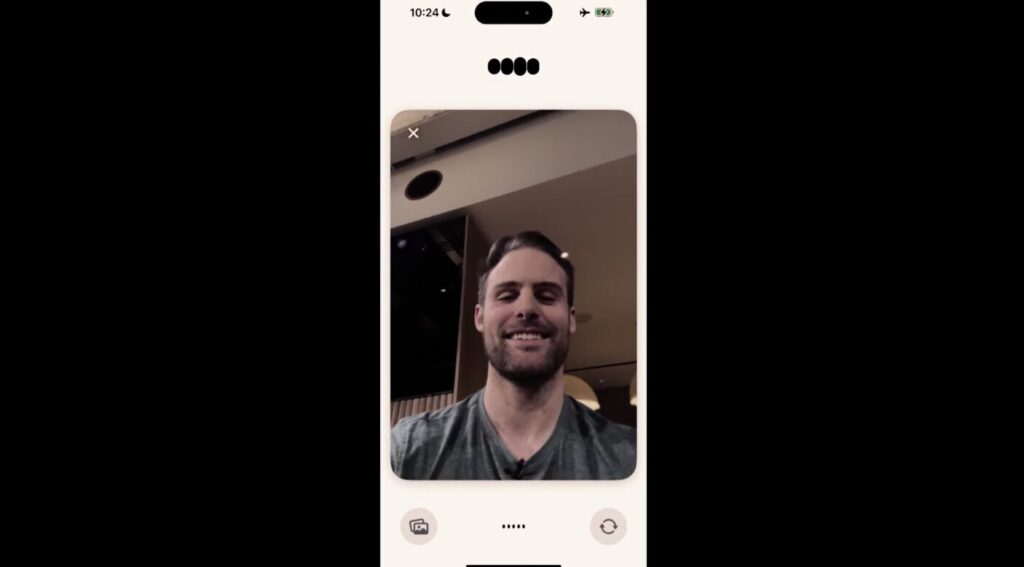

19h25 : ChatGPT Voice peut utiliser la caméra pour commenter des choses en temps réel. Dans cette nouvelle démo, il commente le physique de son utilisateur et le complimente. On est dans Her.

19h23 : L’utilisation détournée de ChatGPT Voice en tant que traducteur (coup dur pour les applis de traduction). On lui demande de traduire en direct ce que dit l’autre, il le fait.

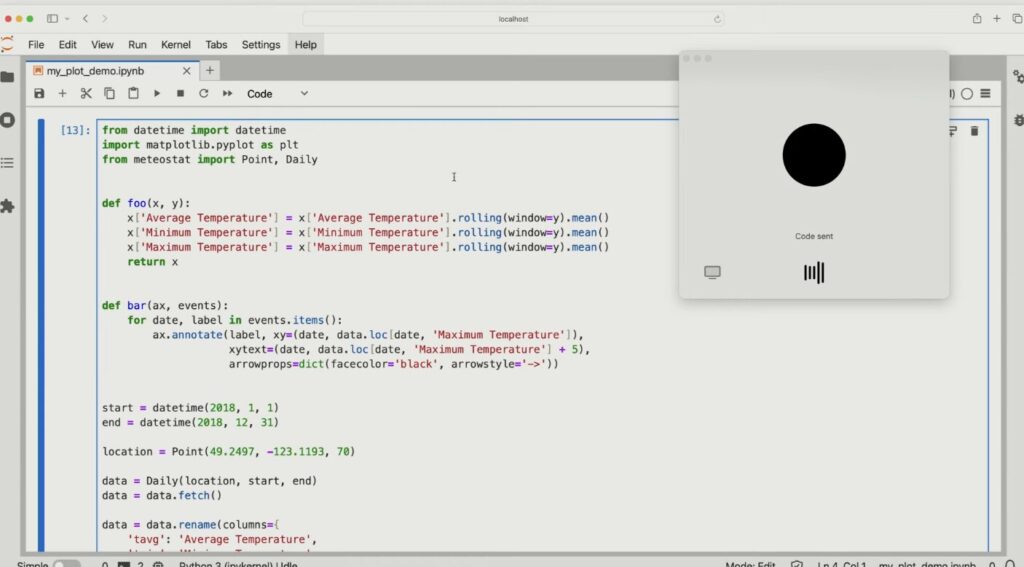

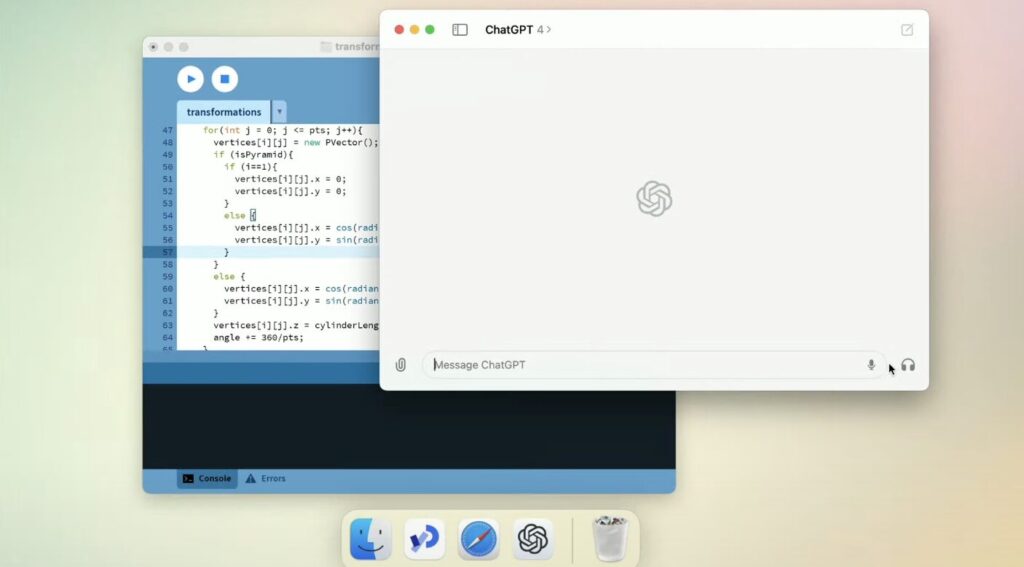

19h19 : Nouvelle démo avec l’appli ChatGPT pour Mac. On lui parle pour lui demander de l’aide sur du code, on copie-colle ce code et il le commente à la voix. Une belle démo de la multimodalité, avec une IA capable de recevoir du texte et de la voix en même temps.

19h15 : Comme le modèle qu’annoncera Google demain, ChatGPT dispose d’un mode Vision capable de commenter un flux vidéo en temps réel. C’est assez dingue. Il commente en parlant ce qu’il voit, avec des blagues et une spontanéité très naturelle.

19h14 : ChatGPT Voice est impressionnant. On peut lui demander de chanter, d’être dramatique, d’imiter une voix robotique. Il imite le comportement humain.

19h11 : Nouveauté importante avec GPT-4o : on peut l’interrompre comme dans une vraie conversation, il reconnaît le ton et n’a pas de délai de réponse.

19h11 : Le nouveau ChatGPT Voice a des intonations encore plus naturelles, répond très rapidement aux questions et fait des blagues. Il n’y a quasiment pas de délai entre la question et la réponse, il imite aussi les respirations humaines et peut donner des conseils d’intonation.

19h10 : Mark Chen et Barret Zoph rejoignent Mira Murati pour des démos de GPT-4o. On nous parle de conversations vocales en temps réel.

19h10 : GPT-4o est aussi accessible des utilisateurs de l’API, avec un temps de réponse annonce 5 fois plus rapide que GPT-4 Turbo.

19h07 : Les GPTs, les versions customisées de ChatGPT, sont désormais disponibles pour les utilisateurs de la version gratuite. Le mode « Vision », pour reconnaître une image, devient aussi gratuit.

19h06 : GPT-4o remplace GPT-4 et GPT-3.5. C’est la première fois qu’OpenAI déploie un nouveau modèle chez tous ses utilisateurs.

19h04 : On passe déjà à GPT-4o, la star du jour. OpenAI promet un nouveau modèle révolutionnaire, son premier « omnimodel », capable de comprendre la voix nativement.

19h02 : Voici ChatGPT pour Mac, une vraie application avec aussi des capacités vocales.

19h01 : Mira Murati, la CTO d’OpenAI, ouvre le bal. Au programme du jour, l’arrivée d’une application desktop de ChatGPT et un nouveau modèle de langage nommé GPT-4o. Les utilisateurs de la version gratuite y auront aussi droit.

19h00 : Coup d’envoi de la conférence OpenAI ! Tous les responsables d’OpenAI s’amusent à entretenir la hype sur Twitter. Ils promettent des annonces « huit fois supérieures aux attentes ».

18h50 : Google réplique ! Sur Twitter, l’entreprise diffuse la vidéo d’un assistant vocal capable de commenter un flux vidéo en direct. OpenAI va avoir de la concurrence. Début dans 10 minutes.

18h30 : Le site openai.com permet désormais de suivre la conférence sur YouTube. Coup d’envoi dans 30 minutes.

18h20 : Selon les dernières rumeurs, OpenAI devrait annoncer un assistant vocal d’un nouveau genre, capables de conversations spontanées et naturelles, sans délai entre les questions et les réponses. D’autres médias ont mentionné l’arrivée d’un moteur de recherche pour concurrencer Google, mais OpenAI a démenti cette information à Numerama.

18h (9h à San Francisco) : C’est l’heure du réveil pour l’auteur de cet article, qui rejoindra Mountain View dans l’après-midi à la veille de la Google I/O. Dans une heure, OpenAI fera des annonces majeures sur ses avancées en matière d’intelligence artificielle. Il s’agira d’une conférence virtuelle, avec de rares invités sur place.

+ rapide, + pratique, + exclusif

Zéro publicité, fonctions avancées de lecture, articles résumés par l'I.A, contenus exclusifs et plus encore.

Découvrez les nombreux avantages de Numerama+.

Vous avez lu 0 articles sur Numerama ce mois-ci

Tout le monde n'a pas les moyens de payer pour l'information.

C'est pourquoi nous maintenons notre journalisme ouvert à tous.

Mais si vous le pouvez,

voici trois bonnes raisons de soutenir notre travail :

- 1 Numerama+ contribue à offrir une expérience gratuite à tous les lecteurs de Numerama.

- 2 Vous profiterez d'une lecture sans publicité, de nombreuses fonctions avancées de lecture et des contenus exclusifs.

- 3 Aider Numerama dans sa mission : comprendre le présent pour anticiper l'avenir.

Si vous croyez en un web gratuit et à une information de qualité accessible au plus grand nombre, rejoignez Numerama+.

Abonnez-vous à Numerama sur Google News pour ne manquer aucune info !